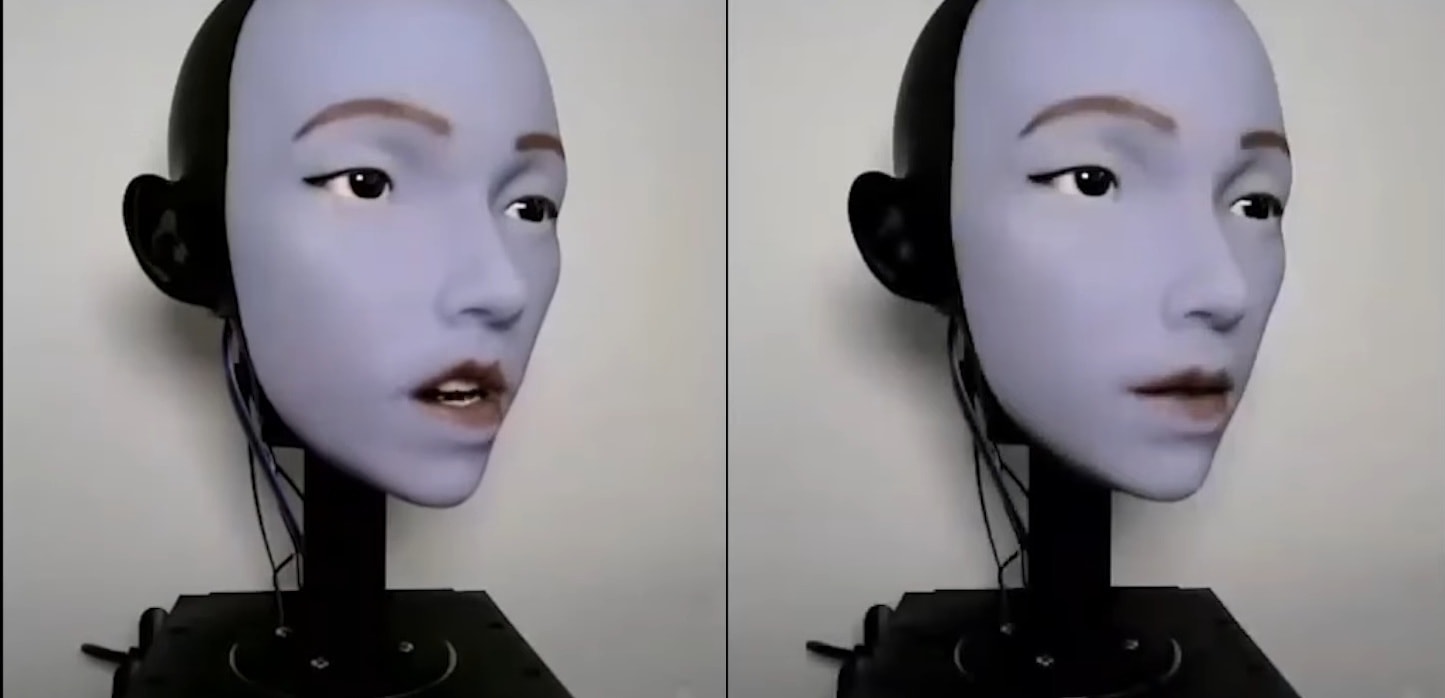

Ich najnowsze dzieło, robot o imieniu Emo, potrafi nie tylko idealnie zsynchronizować ruch warg z mową, ale – co brzmi niemal jak z filmu sci-fi – potrafi przewidzieć Twój wyraz twarzy, zanim jeszcze go w pełni wykonasz. W styczniu 2026 roku robotyka społeczna przeskoczyła kolejną barierę: od zwykłego naśladownictwa do prawdziwej antycypacji emocjonalnej.

Emo to potężny krok naprzód względem swojego poprzednika, Evy

Zamiast 10 siłowników, nowy robot ma ich aż 26, co pozwala na generowanie asymetrycznych, a przez to znacznie bardziej realistycznych grymasów twarzy. Inżynierowie zrezygnowali z systemów cięgnowych na rzecz bezpośrednio montowanych magnesów, które odkształcają wymienną skórę robota z niespotykaną wcześniej precyzją. W oczach Emo ukryto kamery RGB o wysokiej rozdzielczości, które służą mu do ciągłej obserwacji rozmówcy. Ale to nie sprzęt jest tu najważniejszy, lecz “podwójne” oprogramowanie oparte na sieciach neuronowych:

- Model własny (self-model) – pozwala robotowi przewidywać własne ruchy i mimikę.

- Model rozmówcy (conversant model) – analizuje subtelne, niemal niezauważalne zmiany w mięśniach twarzy człowieka, by przewidzieć, jaką emocję ten za chwilę zaprezentuje.

System jest tak szybki, że generuje komendy silnika w zaledwie 0,002 sekundy. Dla porównania, uformowanie ludzkiego wyrazu twarzy trwa zazwyczaj około 0,8 sekundy. To daje robotowi ogromny zapas czasu na “przygotowanie się” i uśmiechnięcie się dokładnie w tym samym momencie, co my. Analiza ponad 2300 komend wykazała, że Emo poprawnie przewiduje aktywację mimiki w ponad 72% przypadków.

Innym przełomem jest technologia lip-sync

Nowy model generuje polecenia dla silników twarzy aż 5 razy szybciej niż dotychczasowe rozwiązania. Dzięki temu ruchy ust robota są niemal idealnie dopasowane do ścieżki dźwiękowej. Co najciekawsze, system wykazuje niesamowite zdolności generalizacji – radzi sobie z synchronizacją mowy w językach, których nie miał w zbiorze treningowym, takich jak francuski, chiński czy arabski.

Czytaj też: Robot z „ludzkim wyczuciem”. Przełom w naśladowaniu dotyku przy minimalnej ilości danych

Naukowcy przetestowali framework na 11 językach nieanglojęzycznych o skrajnie różnej strukturze fonetycznej i w każdym przypadku Emo potrafił dopasować ruchy warg do dźwięku lepiej niż pięć innych, wiodących obecnie metod. To otwiera drzwi do szerokiego zastosowania robotów w edukacji językowej czy opiece nad seniorami, gdzie naturalność komunikacji ma kluczowe znaczenie dla budowania zaufania.

Czytaj też: Robot, który uczy się z YouTube’a. NEO zyskuje „cyfrową wyobraźnię”

Emo to nie tylko kolejny robot z gumową skórą, ale dowód na to, że sztuczna inteligencja zaczyna rozumieć dynamikę ludzkich emocji w czasie rzeczywistym. Zdolność do przewidywania uśmiechu czy smutku rozmówcy sprawia, że interakcja z maszyną przestaje być sztywną wymianą danych, a zaczyna przypominać prawdziwą rozmowę. Jasne, jak zwracają uwagę badacze, naturalna reakcja to nie wszystko, bo dochodzą do tego również różnice kulturowe, jednak tak czy inaczej, Emo jest kamieniem milowym na drodze do stworzenia robotów, które staną się naszymi asystentami i towarzyszami.