Gemini 2.5 Flash-Lite z rewolucyjnym trybem „Myślenia”

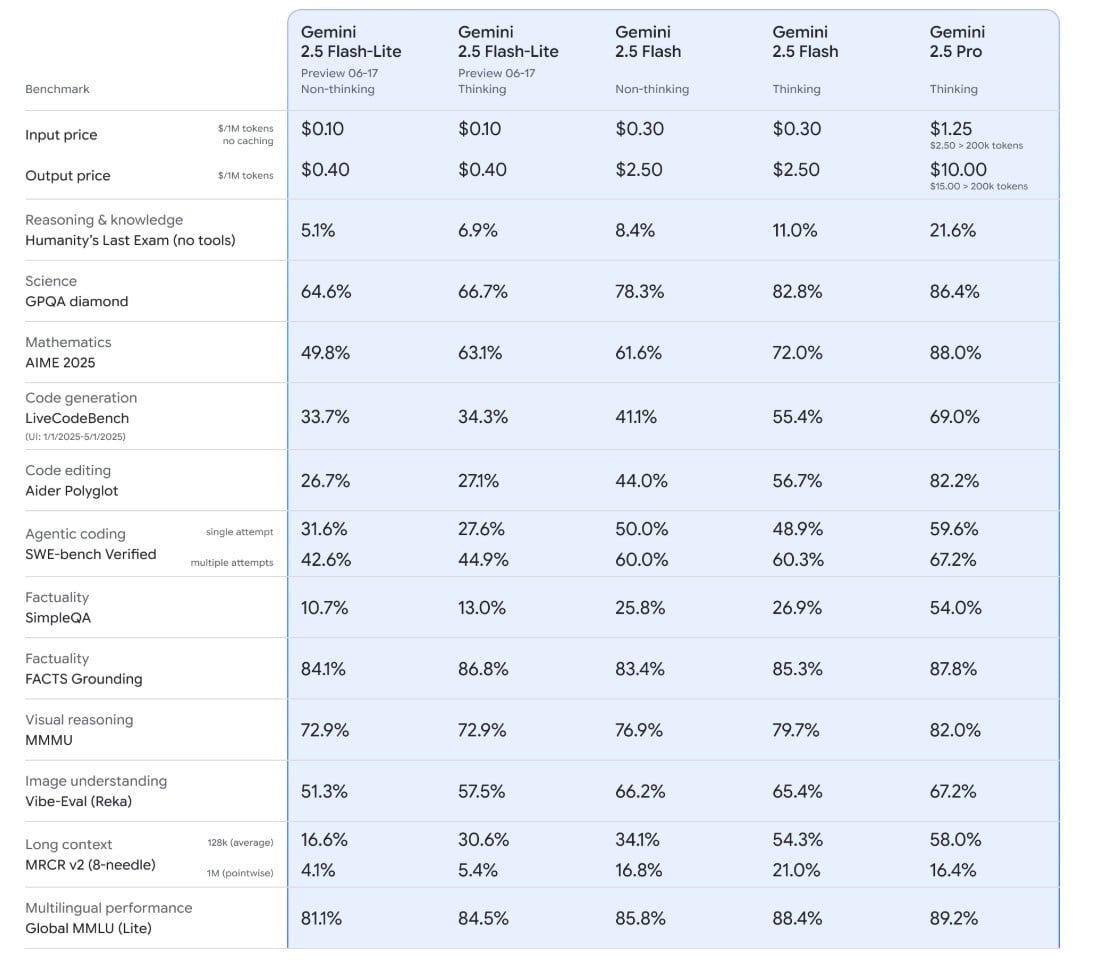

Jak zwykle Google podkreśla, że Flash-Lite przewyższa swoich poprzedników z rodziny 2.0 w kluczowych benchmarkach dotyczących kodowania, matematyki i rozumowania. Jego głównym przeznaczeniem jest obsługa zadań na masową skalę, takich jak tłumaczenia czy klasyfikacja, gdzie kluczową rolę odgrywa szybkość. Odzwierciedla to również jego cena – Flash-Lite jest zdecydowanie najtańszą opcją, kosztując zaledwie 0,10 USD za milion tokenów wejściowych i 0,40 USD za milion tokenów wyjściowych. Mimo to, jego bazowa wydajność w trudnych zadaniach rozumowania jest dość niska, osiągając zaledwie 5,1% w teście “Humanity’s Last Exam”. Pełny raport techniczny znajdziecie tutaj.

Czytaj też: Siri z AI dopiero w przyszłym roku? Czekanie na rewolucję się przedłuża

Cała magia zaczyna się jednak w chwili, w której aktywowany jest tryb “Myślenia” (Thinking mode). Wówczas Gemini 2.5 Flash-Lite potrzebuje co prawda więcej czasu na przetworzenie zapytania, jednak ego możliwości dramatycznie rosną. Przykład? Wydajność w trudnym benchmarku matematycznym AIME 2025 skacze z 49,8% do imponujących 63,1%. Podobny wzorzec obserwuje się w testach zdolności do wyszukiwania informacji w dużych dokumentach, gdzie jego zdolność do przypominania sobie danych niemal podwaja się. Google udostępnił również szczegółową tabelę z benchmarkami, która obrazuje te skoki wydajności.

Czytaj też: Ile energii i wody zużywa ChatGPT? Sam Altman odsłania kulisy

Zgodnie z ogłoszeniem giganta, deweloperzy mogą już eksperymentować z nowym modelem – wersja podglądowa Gemini 2.5 Flash-Lite jest już dostępna poprzez Google AI Studio oraz platformę Vertex AI, przeznaczoną dla programistów. Bardziej stabilne i potężne wersje 2.5 Flash i Pro również można znaleźć w tych samych miejscach, ale są one dodatkowo zintegrowane z główną aplikacją Gemini dla zwykłych użytkowników.

Czytaj też: Wikipedia pod ostrzałem własnej społeczności. Kontrowersyjna funkcja wstrzymana

Tutaj warto też wspomnieć, że Google zdradził, iż niestandardowe wersje zarówno Flash-Lite, jak i Flash, już teraz zasilają niektóre części ich własnej wyszukiwarki. Celem jest dostarczanie jeszcze lepszych wyników wyszukiwania w krótszym czasie, oszczędzając użytkownikom czas, jaki normalnie musieliby poświęcić na samodzielne wyszukiwanie skomplikowanych informacji. Wszystkie te działania pokazują, jak głęboko te technologie są osadzone w ekosystemie giganta z Mountain View i jak bardzo firma w nie inwestuje. Biorąc pod uwagę fakt, że Google i OpenAI prześcigają się w prezentowaniu kolejnych modeli, można się spodziewać, że wkrótce właściciel ChatGPT też wykona swój ruch.